Server AI – “Quái thú” tính toán vượt xa máy chủ thông thường

Trong thời đại trí tuệ nhân tạo (AI) đang len lỏi vào mọi lĩnh vực, từ nghiên cứu khoa học, sản xuất, y tế đến tài chính và dịch vụ, nhu cầu về một hệ thống tính toán chuyên biệt trở nên cấp thiết. Server AI ra đời để đáp ứng yêu cầu đó, một nền tảng phần cứng tối ưu cho huấn luyện (training) và suy luận (inference) AI, giúp xử lý khối lượng dữ liệu khổng lồ với tốc độ vượt trội so với máy chủ thông thường.

1. Sức mạnh tính toán: Không chỉ mạnh, mà còn được “thiết kế cho AI”

Máy chủ AI không đơn giản chỉ là gắn thêm GPU vào máy chủ thông thường. Từ kiến trúc bo mạch, hệ thống cấp nguồn, băng thông dữ liệu cho đến phần mềm điều khiển đều được thiết kế để tối đa hóa hiệu suất AI.

- GPU/TPU chuyên dụng như NVIDIA H100, A100, L40S hoặc AMD Instinct cung cấp hàng nghìn nhân xử lý song song, hỗ trợ tính toán tensor – yếu tố cốt lõi trong deep learning.

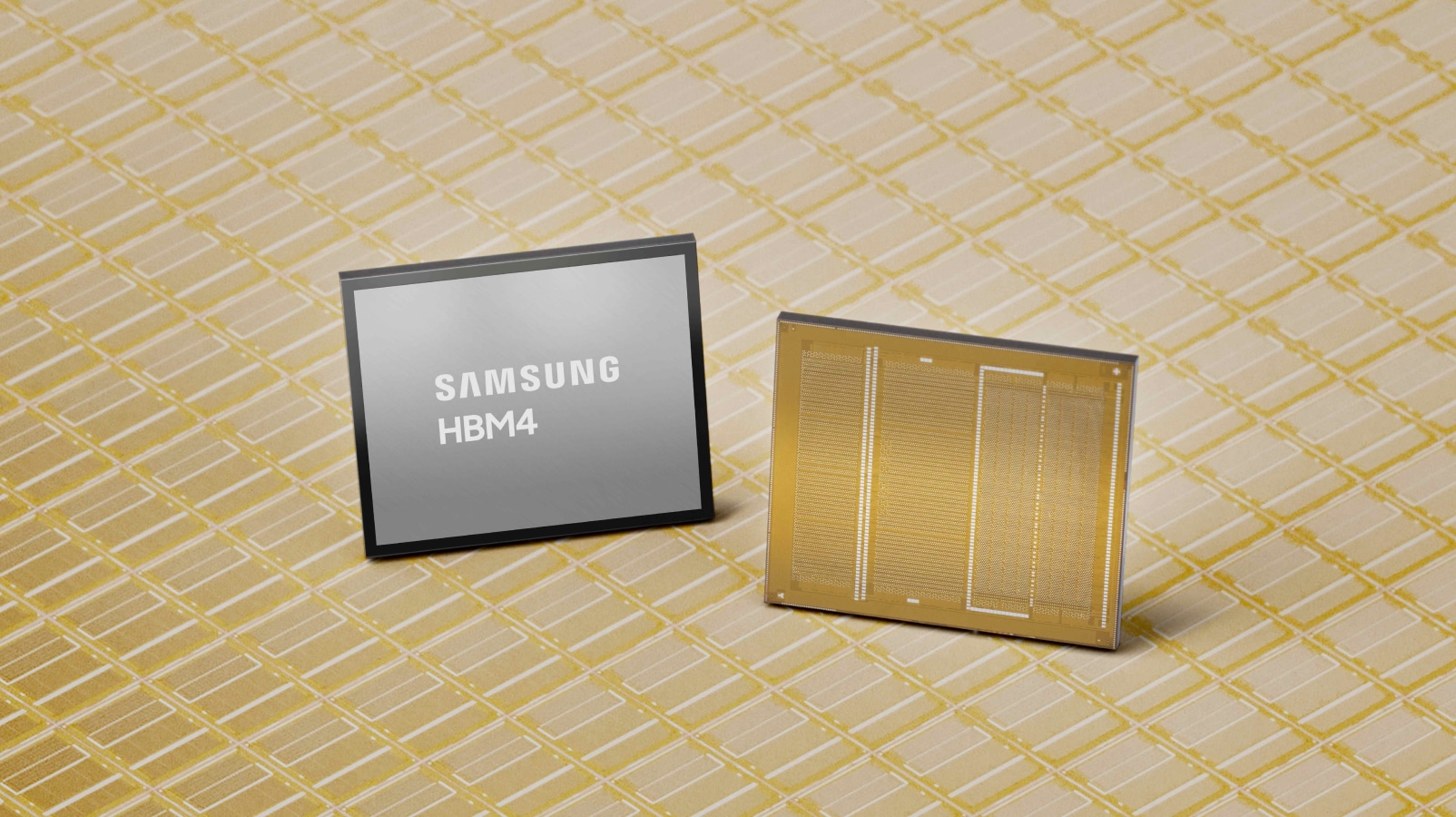

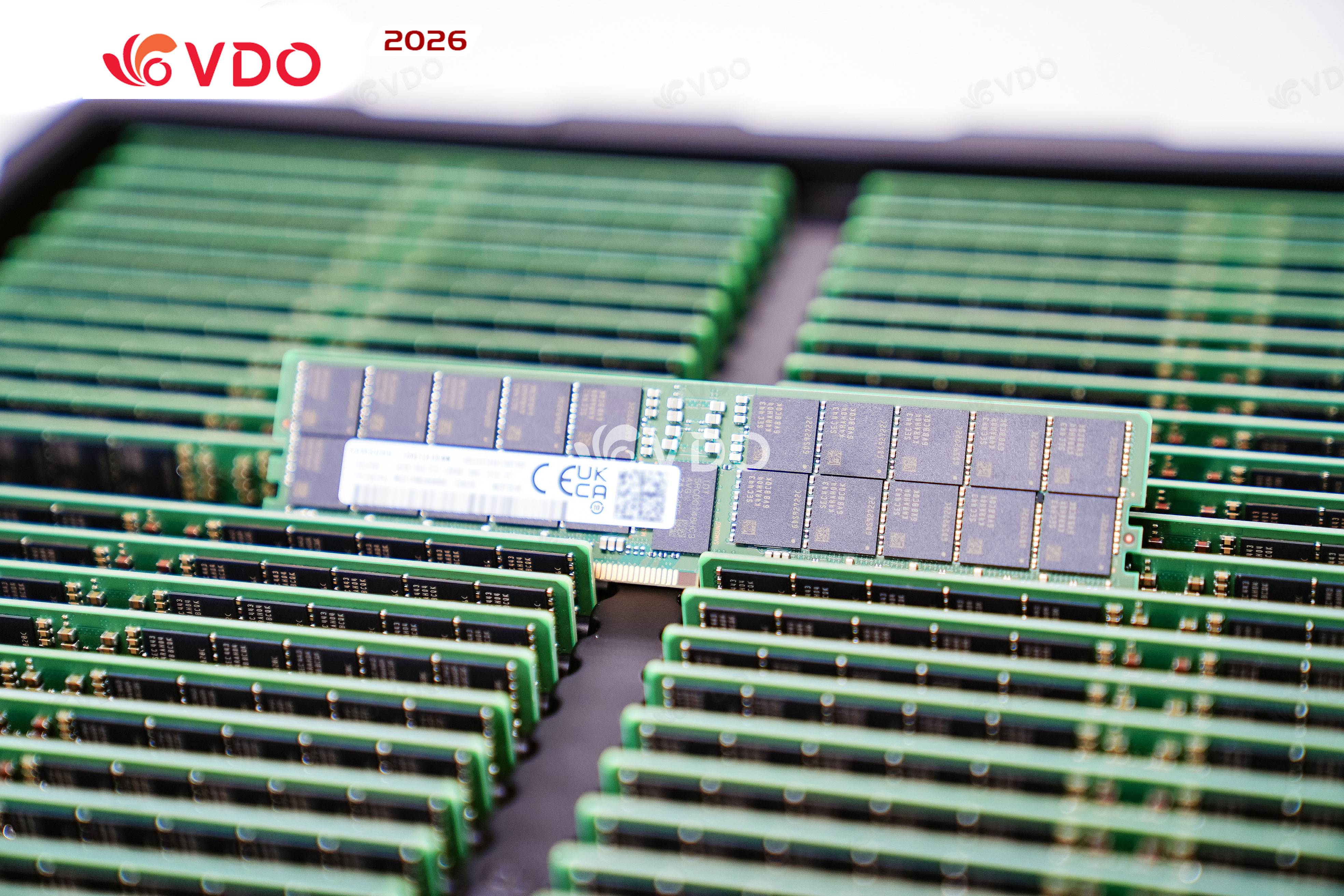

- Bộ nhớ HBM trên GPU và RAM DDR5/CXL trên hệ thống giúp giảm độ trễ truy xuất dữ liệu, tăng tốc huấn luyện mô hình lên nhiều lần so với DDR4 truyền thống.

- PCIe Gen5 hoặc NVLink cho phép giao tiếp dữ liệu tốc độ cao giữa GPU và CPU, giảm “điểm nghẽn” khi xử lý khối lượng tính toán lớn.

Nếu một server thường mất 10 ngày để huấn luyện một mô hình thị giác máy tính (computer vision), thì với Server AI cấu hình cao, thời gian này có thể rút xuống chỉ còn 2–3 ngày, tiết kiệm đáng kể thời gian triển khai dự án.

.jpg)

2. Khả năng xử lý dữ liệu lớn: Vượt giới hạn của hạ tầng cũ

Dữ liệu AI ngày nay không chỉ lớn về dung lượng mà còn phức tạp về định dạng – hình ảnh, video, âm thanh, dữ liệu IoT liên tục đổ về. Server AI giải quyết bằng:

- RAM hàng TB để lưu trữ và xử lý batch dữ liệu lớn trong bộ nhớ thay vì phải truy xuất liên tục từ ổ cứng.

- Lưu trữ NVMe Gen4/Gen5 cho tốc độ đọc/ghi lên tới hàng chục GB/s, rút ngắn thời gian load dataset.

- Kết nối mạng 25GbE/100GbE hoặc InfiniBand giúp phân tán dữ liệu và đồng bộ mô hình nhanh khi chạy cụm (cluster).

Trong môi trường AI phân tán, nếu hạ tầng mạng chậm, thời gian chờ truyền dữ liệu có thể chiếm hơn 50% tổng thời gian huấn luyện. Server AI giải quyết điểm nghẽn này, giúp GPU hoạt động liên tục và đạt hiệu suất tối đa.

.jpg)

3. Hệ thống làm mát và nguồn điện: Điều kiện sống của “quái thú”

Hiệu suất cao đồng nghĩa với nhiệt lượng và điện năng tiêu thụ lớn:

- Một GPU AI cao cấp tiêu thụ 350–700W, nếu hệ thống có 8 GPU, tổng mức tiêu thụ có thể vượt 5kW.

- Giải pháp làm mát phải đủ mạnh để đảm bảo GPU luôn ở nhiệt độ lý tưởng, tránh giảm xung (thermal throttling).

- Nhiều trung tâm dữ liệu chuyển sang làm mát chất lỏng (liquid cooling) để giảm tiếng ồn, tiết kiệm diện tích và duy trì hiệu suất bền vững.

Hệ thống làm mát kém có thể khiến hiệu suất giảm tới 30%, đồng nghĩa chi phí đầu tư đắt đỏ nhưng không khai thác hết năng lực phần cứng.

4. Mục đích và chi phí: Chọn đúng để tối ưu ROI

- Server thường: Hosting web, lưu trữ dữ liệu, chạy ERP, quản lý cơ sở dữ liệu… ưu tiên tính ổn định và chi phí hợp lý.

- Server AI: Huấn luyện mô hình deep learning, phân tích dữ liệu lớn, AI thị giác, nhận dạng giọng nói, chatbot, phân tích ngôn ngữ tự nhiên… ưu tiên hiệu suất và tốc độ.

Chi phí đầu tư ban đầu cho Server AI thường cao gấp nhiều lần so với server thông thường, nhưng với doanh nghiệp làm AI chuyên sâu, lợi ích về rút ngắn thời gian R&D, tăng tốc đưa sản phẩm ra thị trường sẽ giúp bù đắp chi phí nhanh chóng.

Server AI = Máy chủ thông thường + GPU/TPU chuyên dụng + băng thông & lưu trữ siêu nhanh + hệ thống tản nhiệt & nguồn công suất lớn.

Đây là “cỗ máy bắt buộc” nếu doanh nghiệp hoặc trung tâm nghiên cứu muốn đạt hiệu suất AI tối đa – điều mà hạ tầng máy chủ truyền thống khó lòng đáp ứng.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan