Đắt đỏ nhưng không thể thiếu: Vì sao HBM4 dẫn dắt kỷ nguyên GPU AI?

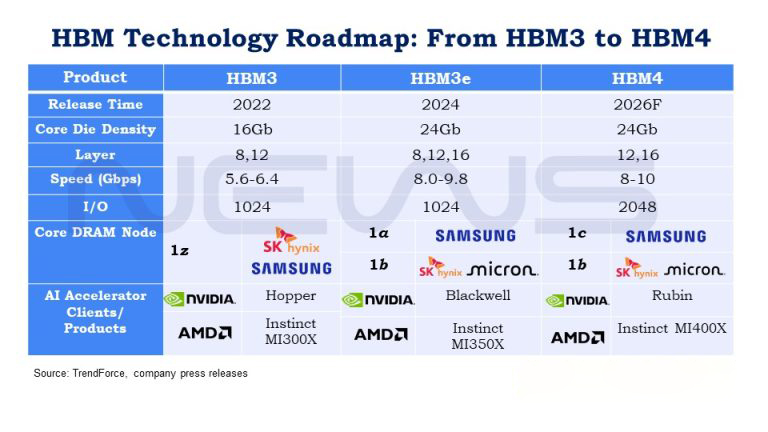

Trong bối cảnh các ông lớn như SK hynix, Micron và Samsung dự kiến tăng tốc sản xuất HBM4 từ cuối năm 2025 đến 2026, đây là thời điểm phù hợp để tìm hiểu HBM (High Bandwidth Memory) - bộ nhớ băng thông cao đang làm thay đổi ngành AI. Bài viết này sẽ giải thích HBM là gì, vì sao nó quan trọng, thách thức trong sản xuất và vì sao HBM4 đang định hình lại thị trường bán dẫn.

HBM là gì và vì sao quan trọng cho AI?

Các mô hình AI ngày càng lớn, vừa cần xử lý huấn luyện chuyên sâu, vừa phải suy luận theo thời gian thực. Điều đó đòi hỏi bộ nhớ đáp ứng 3 yếu tố: dung lượng lớn, tốc độ cao và hiệu quả năng lượng.

- SRAM: nhanh nhưng dung lượng thấp.

- DRAM truyền thống: lưu trữ nhiều nhưng băng thông hạn chế.

- HBM: giải pháp cân bằng, vừa nhanh vừa đủ lớn để phục vụ AI.

HBM đạt được điều này nhờ kiến trúc xếp chồng nhiều lớp chip DRAM lên một chip nền (logic die) và kết nối qua hàng nghìn kênh song song. Toàn bộ khối HBM được gắn với GPU qua lớp silicon đặc biệt, thường thấy trên các card đồ họa NVIDIA.

HBM có rất nhiều ưu điểm so với các bộ nhớ trước đó:

- Tiết kiệm điện: Đường truyền dữ liệu ngắn hơn nên tiêu thụ ít năng lượng.

- Băng thông khổng lồ: Một module DDR4 chỉ đạt 25,6 GB/s, trong khi một khối HBM4 có thể đạt hơn 1 TB/s, nhanh gấp hàng chục lần.

Trong 20 năm qua, sức mạnh GPU tăng 60.000 lần, nhưng băng thông DRAM chỉ tăng khoảng 100 lần, tạo ra “bức tường bộ nhớ” (memory wall). Dù GPU mạnh đến đâu, nếu bộ nhớ không cung cấp dữ liệu đủ nhanh thì hiệu năng vẫn bị nghẽn. HBM, với kiến trúc xếp chồng giống “tòa nhà chọc trời”, đã ra đời để phá vỡ rào cản này.

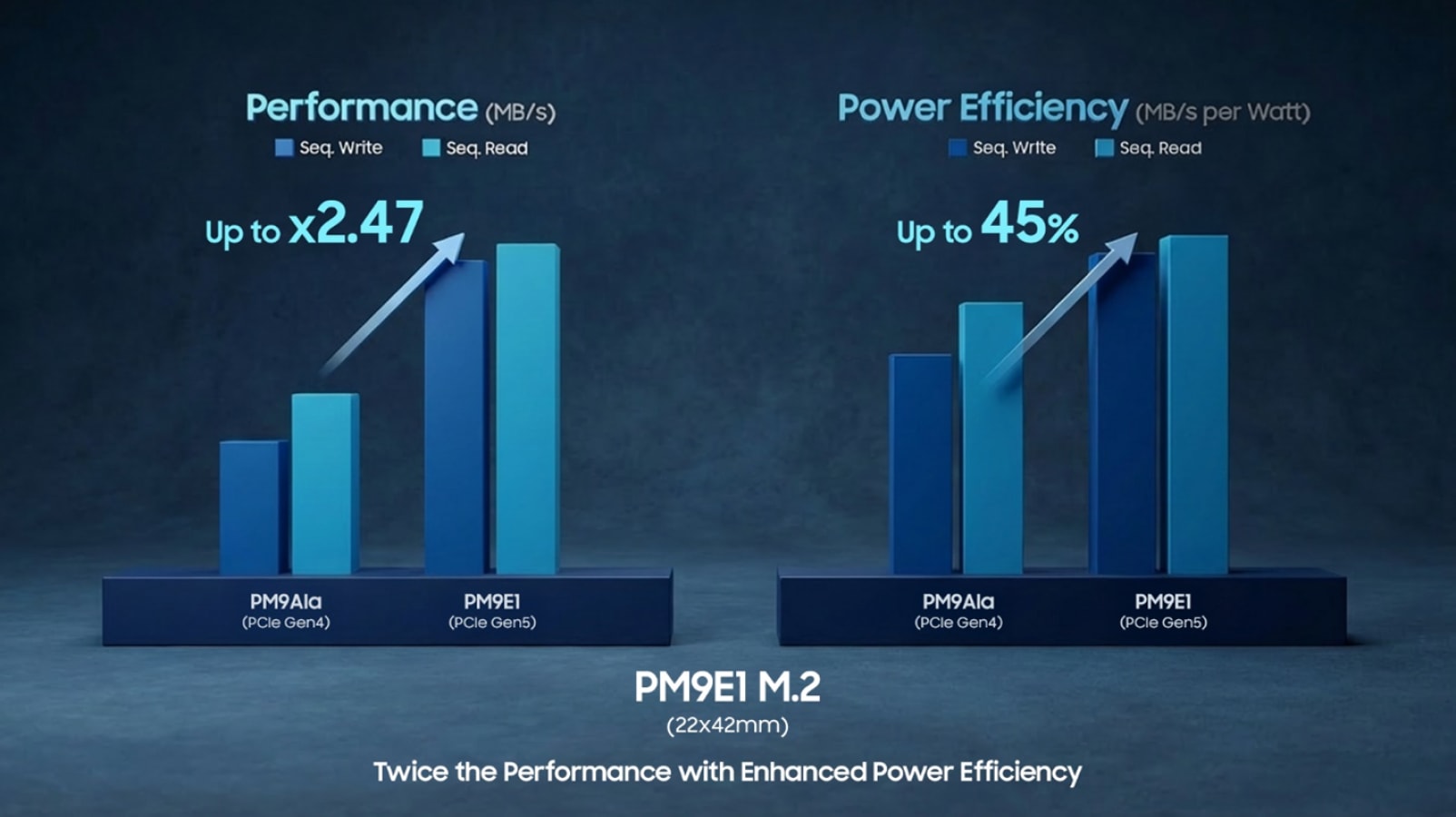

HBM Samsung có đường truyền dữ liệu ngắn hơn nên tiêu thụ ít năng lượng

Thách thức và chi phí sản xuất

HBM cực kỳ khó chế tạo, gần như “xây cao ốc vi mô”. Theo TrendForce, HBM3e đã có giá cao hơn khoảng 20% so với bộ nhớ thường, và HBM4 dự kiến sẽ đắt hơn 30% nữa. Lý do là:

- Thiết kế chip phức tạp hơn, nhiều kênh kết nối hơn.

- Nhu cầu sử dụng nền logic die chuyên biệt.

Một thách thức đặc biệt của HBM4 là nền logic die phải xử lý hơn 2.000 điểm kết nối (từ 1.024 đến 2.048 I/O) với khoảng cách chỉ 6-9 micromet, mỏng gấp 100 lần sợi tóc. Chính điều này khiến các foundry như TSMC đóng vai trò trung tâm, tham gia trực tiếp vào phát triển HBM4 với SK hynix và HBM4E với Micron. Ngoài ra, các công nghệ tiên tiến như MR-MUF, TC-NCF và hybrid bonding cũng đang được triển khai để tăng độ bền và hiệu quả.

HBM: cuộc chơi độc quyền và đầy cạnh tranh

Sản xuất HBM không phải dành cho tất cả. Đây là “sân chơi độc quyền” của vài ông lớn:

- SK hynix: được dự báo chiếm 59% thị phần HBM năm 2025.

- Samsung và Micron: mỗi hãng khoảng 20%.

Khách hàng trọng tâm là NVIDIA và AMD, với GPU thế hệ tiếp theo Rubin và MI400 đều sẽ trang bị HBM4. Thông số JEDEC cũng cho thấy HBM4 đã tiến thêm một bước, với độ dày gói danh nghĩa cho các cụm 12-high và 16-high tăng lên 775 µm, so với 720 µm ở HBM3, mở đường cho dung lượng lớn hơn và độ ổn định cao hơn.

HBM không chỉ là xu hướng, mà là nền tảng bắt buộc cho kỷ nguyên AI. HBM4 với gấp đôi số I/O, băng thông vượt trội và vai trò trung tâm của logic die đã biến thị trường thành “đấu trường” công nghệ, nơi các hãng bộ nhớ lớn và các foundry hàng đầu cùng hợp tác, vừa cạnh tranh vừa liên minh. Cuộc đua này không chỉ quyết định ai dẫn đầu về công nghệ, mà còn định hình toàn bộ hệ sinh thái bán dẫn toàn cầu.

HBM4 – Bộ nhớ định hình kỷ nguyên AI

Trong 20 năm, sức mạnh GPU đã tăng tới 60.000 lần, nhưng băng thông DRAM chỉ tăng khoảng 100 lần, tạo ra “bức tường bộ nhớ”. Để phá vỡ giới hạn này, HBM ra đời với kiến trúc xếp chồng độc đáo, mang lại băng thông hơn 1 TB/s, tiết kiệm điện năng 40-50% so với DDR4.

HBM4 thế hệ mới nhất dự kiến tăng tốc sản xuất từ 2025. Tuy chi phí sản xuất cao hơn khoảng 30% so với HBM3e, nhưng đổi lại, nó mở ra khả năng huấn luyện và vận hành các mô hình AI khổng lồ, nơi tốc độ truy cập dữ liệu là yếu tố sống còn.

Samsung đang cùng các tên tuổi lớn đầu tư mạnh vào HBM4, sẵn sàng cho cuộc đua AI toàn cầu. Đây không chỉ là xu hướng, mà là nền tảng bắt buộc của kỷ nguyên trí tuệ nhân tạo.

Trong khi sức mạnh GPU liên tục được nâng cấp, thì bộ nhớ HBM mới chính là “nút thắt cổ chai” quyết định hiệu năng AI. Các “ông lớn” như Samsung, SK hynix, Micron đang chạy đua để thương mại hóa HBM4 và giành chứng nhận từ NVIDIA.

Theo TrendForce, SK hynix dự kiến dẫn đầu với 59% thị phần HBM4 vào năm 2025, trong khi Samsung và Micron mỗi bên nắm khoảng 20%. Điều này cho thấy HBM vẫn là “sân chơi” của số ít nhà sản xuất, bởi độ phức tạp và chi phí cực cao.

Trên “chiến trường” GPU, NVIDIA đã công bố Rubin, còn AMD chuẩn bị ra mắt MI400 – cả hai đều dự kiến tích hợp HBM4, hứa hẹn bùng nổ nhu cầu. Với vị thế hiện tại, Samsung chắc chắn sẽ là đối thủ đáng gờm trong cuộc đua này.

Các doanh nghiệp Cloud & AI cần theo sát biến động thị trường bộ nhớ để kịp thời có chiến lược dự trữ, tránh rủi ro khan hiếm.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan