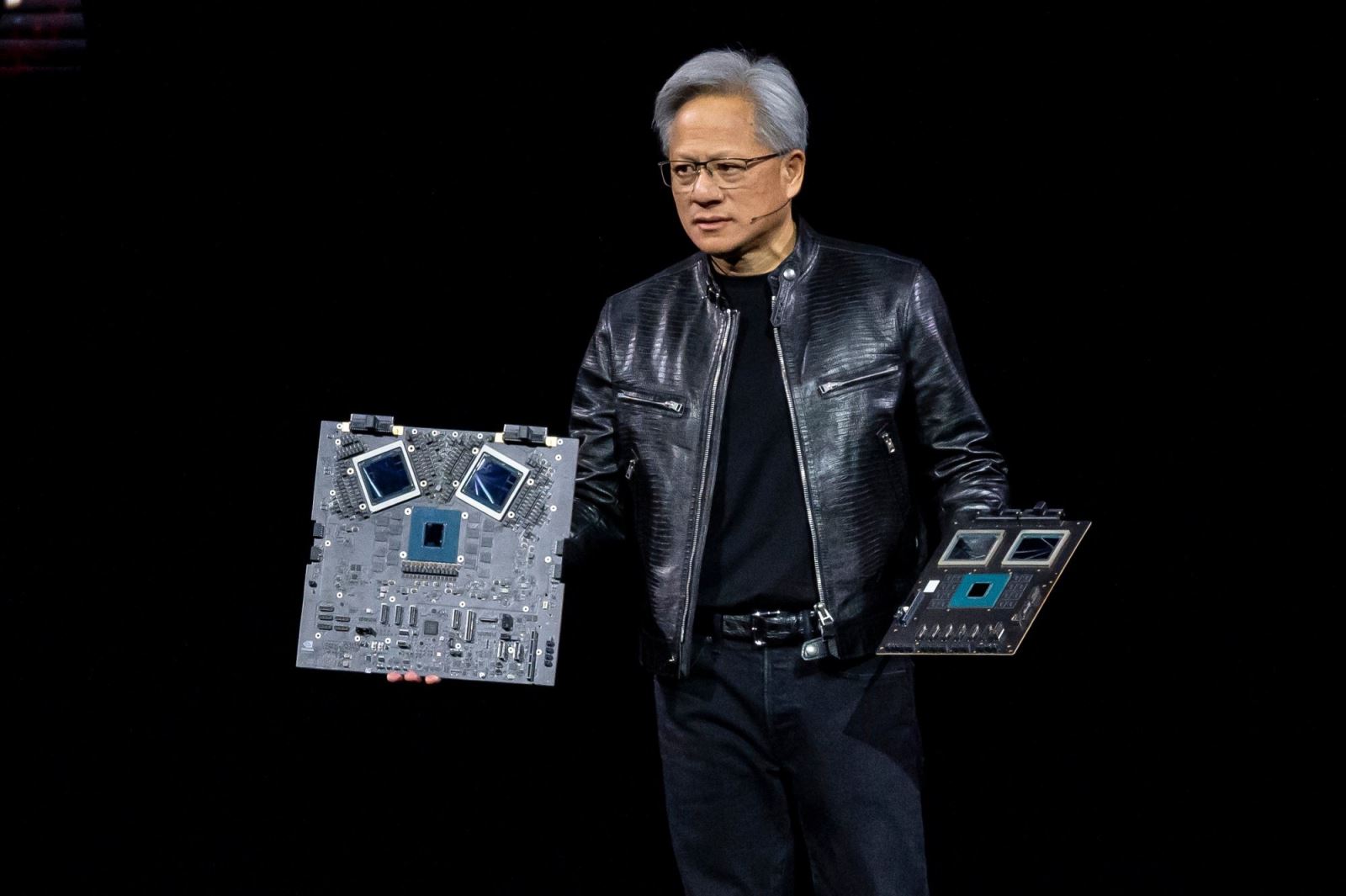

Nvidia Blackwell B200: Chip AI mạnh nhất thế giới, mạnh hơn H200 từ 2.5 đến 5 lần, thiết kế chiplet

GPU mạnh nhất của kiến trúc Blackwell cũng đã được chính thức ra mắt. Và điều gây bất ngờ nhất, đó là die B200 không phải một die silicon dạng monolithic, mà là một thiết kế chiplet ghép 2 GPU lại với nhau.

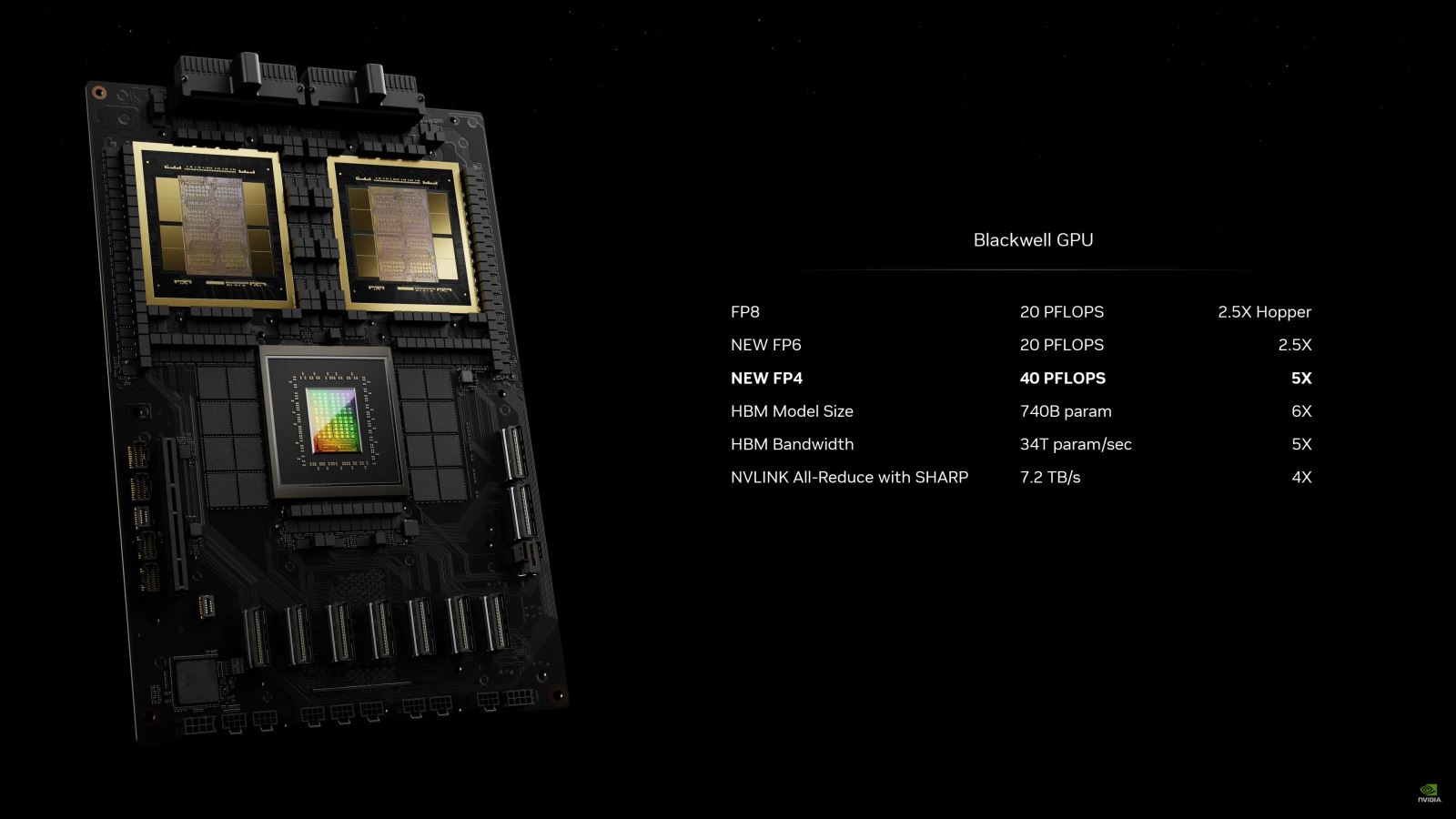

Những thông số kỹ thuật chính của Blackwell B200 được Nvidia công bố:

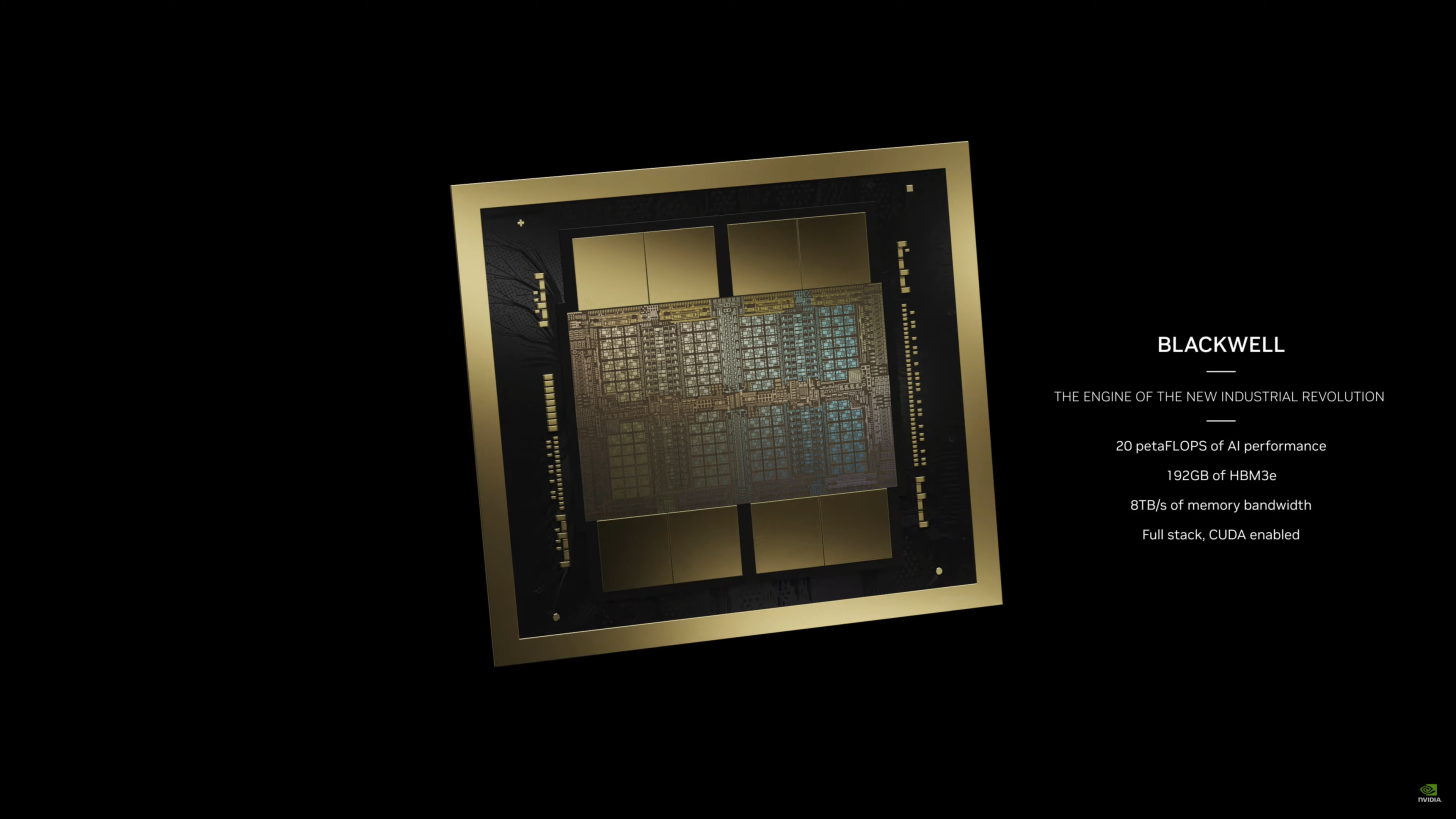

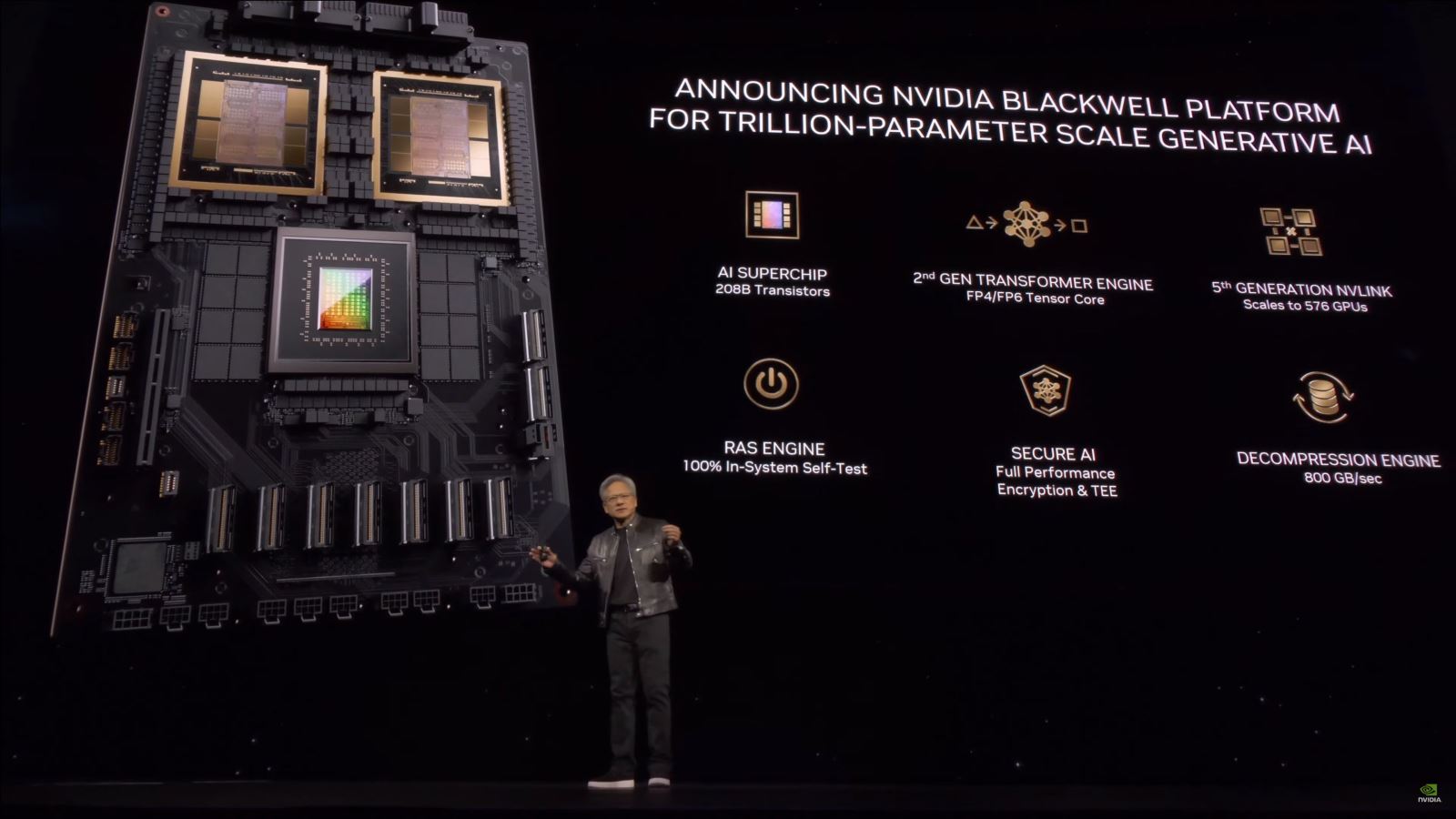

Chip mạnh nhất hành tinh: 208 tỷ transistor, gia công trên tiến trình 4NP của TSMC, với 2 die silicon kích thước tối đa ghép lại với nhau bằng cầu nối 10TB/s, tạo ra một GPU kích thước cực lớn.

Transformer Engine thế hệ 2, hỗ trợ khả năng nội suy AI số thực dấu phẩy động 4-bit và 6-bit hoàn toàn mới, bên cạnh 8-bit, từ đó vận hành huấn luyện hoặc xử lý mô hình AI với kích thước mô hình gấp đôi, hiệu năng xử lý cũng cao gấp đôi.

Cầu nối NVLink thế hệ 5: Đủ sức mạnh tăng tốc xử lý những mô hình ngôn ngữ với hàng nghìn tỷ tham số, hay những mô hình AI chuyên biệt, với băng thông bộ nhớ hai chiều tổng cộng 1.8 TB/s, hỗ trợ vận hành tối đa 576 GPU trong một cụm máy chủ, vận hành những LLM phức tạp nhất.

RAS Engine: Cụm nhân xử lý đảm bảo hiệu quả vận hành của toàn bộ hệ thống, viết tắt của Reliability, Availability & Serviceability. Nhờ cụm nhân chuyên biệt này, GPU kiến trúc Blackwell có thể chạy thuật toán AI dự báo về những vấn đề có khả năng xảy ra, từ đó đảm bảo dịch vụ vận hành hoàn hảo nhiều tuần hay nhiều tháng mà không cần kỹ thuật viên can thiệp, giảm chi phí vận hành dịch vụ.

Secure AI: Vận hành những mô hình AI phục vụ doanh nghiệp và các tổ chức nhưng cùng lúc đảm bảo an toàn bảo mật dữ liệu của các đơn vị và tổ chức, bao gồm cả những bên nghiên cứu khoa học, quân sự, y tế và tài chính.

Decompression Engine: Cụm nhân xử lý chuyên biệt hỗ trợ những format dữ liệu mới nhất, tăng tốc xử lý và truy xuất cơ sở dữ liệu để tạo hiệu năng phân tích dữ liệu nhanh nhất.

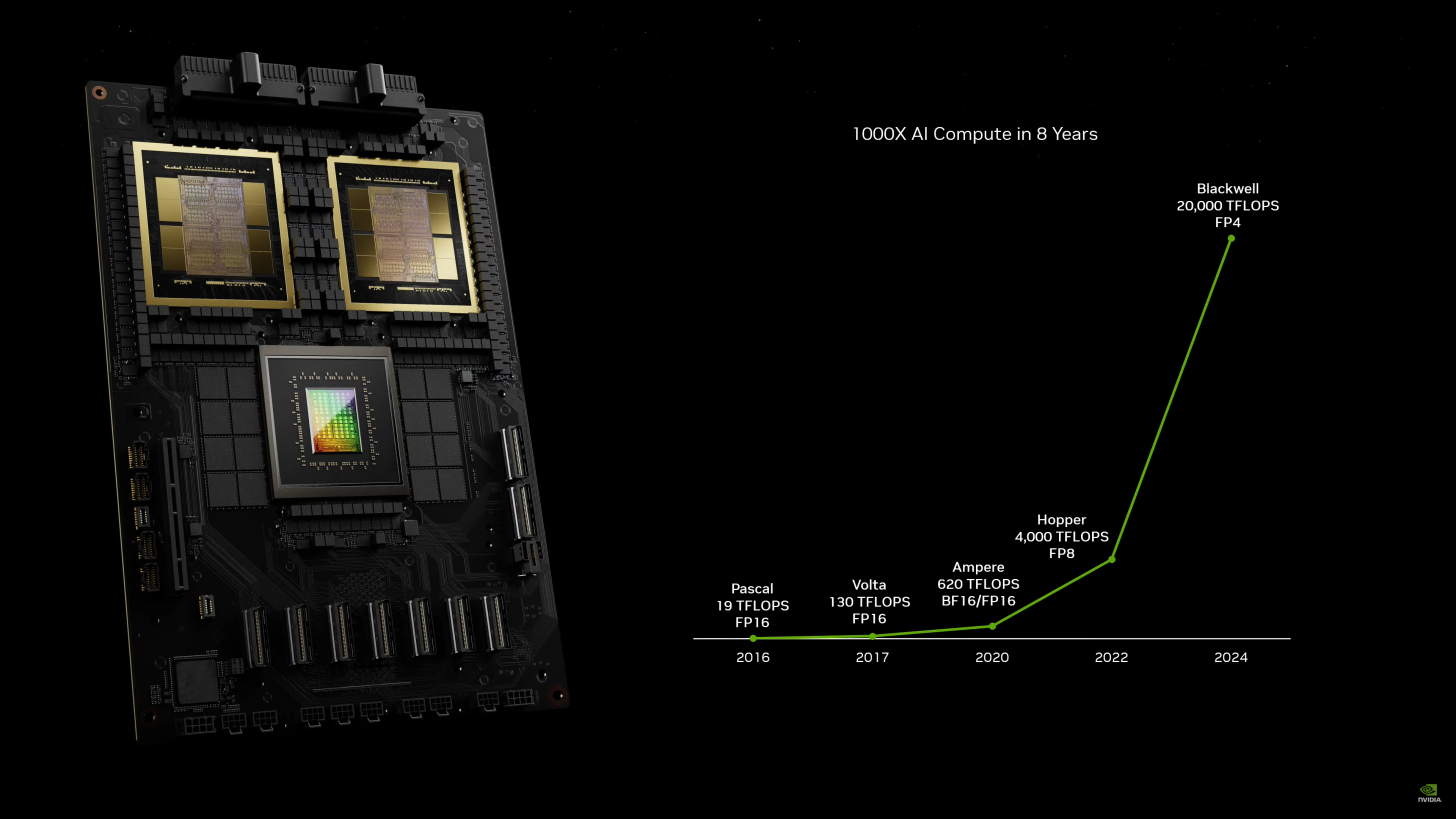

Về chi tiết, GPU B200 sở hữu 104 tỷ transistor trên mỗi die GPU, tổng cộng 2 die MCM là 208 tỷ transistor, chia thành 160 Stream Microprocessor, tức 20480 nhân CUDA. Con chip xử lý này, được hợp tác gia công bởi Synopsys và TSMC, ứng dụng công nghệ và thư viện phần mềm CuLitho của Nvidia, ứng dụng sức mạnh của máy tính để tăng tốc độ nghiên cứu phát triển chip. So sánh với Hopper, B200 nhiều hơn H200 tới 128 tỷ transistor. Sức mạnh xử lý số thực dấu phẩy động FP8 và FP6 của B200 nhanh gấp 2.5 lần, xử lý FP4 nhanh gấp 5 lần so với H200.

Ngay trên bề mặt con chip là 8 stack chip nhớ HBM3e, dung lượng tối đa 192GB, tốc độ 8TB/s, chạy trên bus interface 8192-bit. Công suất tiêu thụ điện tối đa của con chip này lên tới 700W, nhưng con số này giống hệt như H100 và H200 đang có trên thị trường, đang trang bị trong những hệ thống data center vận hành mô hình AI của các tập đoàn lớn.

Về mặt ứng dụng, B200 sẽ có một lựa chọn duy nhất, một platform bao gồm 2 chip B200, tức 4 die GPU, kèm thêm CPU Grace với 72 nhân CPU kiến trúc ARM Neoverse V2. Hai GPU và CPU Blackwell và Grace sẽ kết nối với nhau thông qua giao thức NVLink băng thông 900 GB/s. Điều này đồng nghĩa với việc, sẽ không có những giải pháp card PCIe hay những hệ thống như Grace Hopper, 1 CPU 1 GPU, hoặc hai GPU H100/H200 vận hành độc lập trong những cluster điện toán đám mây và data center cho các doanh nghiệp tự do lựa chọn.

Cũng cần phải nói thêm về GB200, hệ thống trang bị GPU B200 mới nhất của Nvidia, giải pháp thương mại mà hãng vừa công bố. Bên cạnh 192GB bộ nhớ HBM3e trên die chip B200, vì là một hệ thống máy tính hoàn chỉnh, nên vẫn có RAM riêng để cung cấp dữ liệu cho những con chip. GB200 sẽ được trang bị tổng cộng 864GB RAM. Mỗi “superchip” này sẽ tạo ra sức mạnh xử lý INT8 40 petaflop, và được kết nối với nhau thông qua giao thức NVLink băng thông 3.6 TB/s.

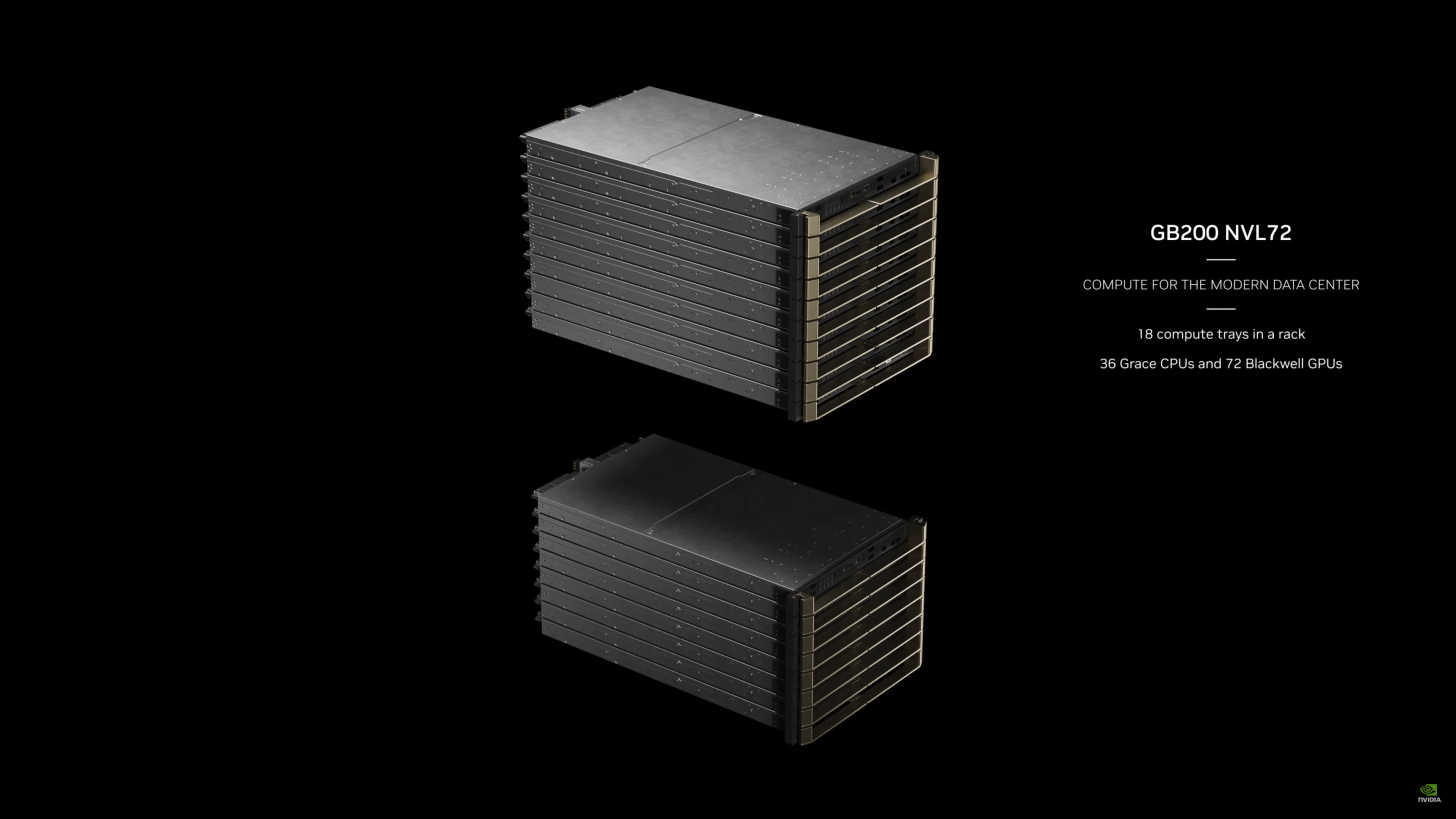

Cả ba con chip trang bị trên GB200 đều ngốn điện, tối đa có thể lên tới 2700W. Và hệ thống này hỗ trợ chuẩn kết nối PCIe 6.0 (2x256 GB/s). Áp “siêu chip” theo cách Nvidia gọi GB200 vào những cụm máy chủ, thì một server blade sẽ bao gồm hai board GB200, 4 GPU, 2 CPU, tạo ra sức mạnh 80 petaflop xử lý AI, 1.7GB bộ nhớ HBM3e, băng thông bộ nhớ 32 TB/s, và được làm mát bằng chất lỏng. Nvidia gọi server blade này là Blackwell Compute Node.

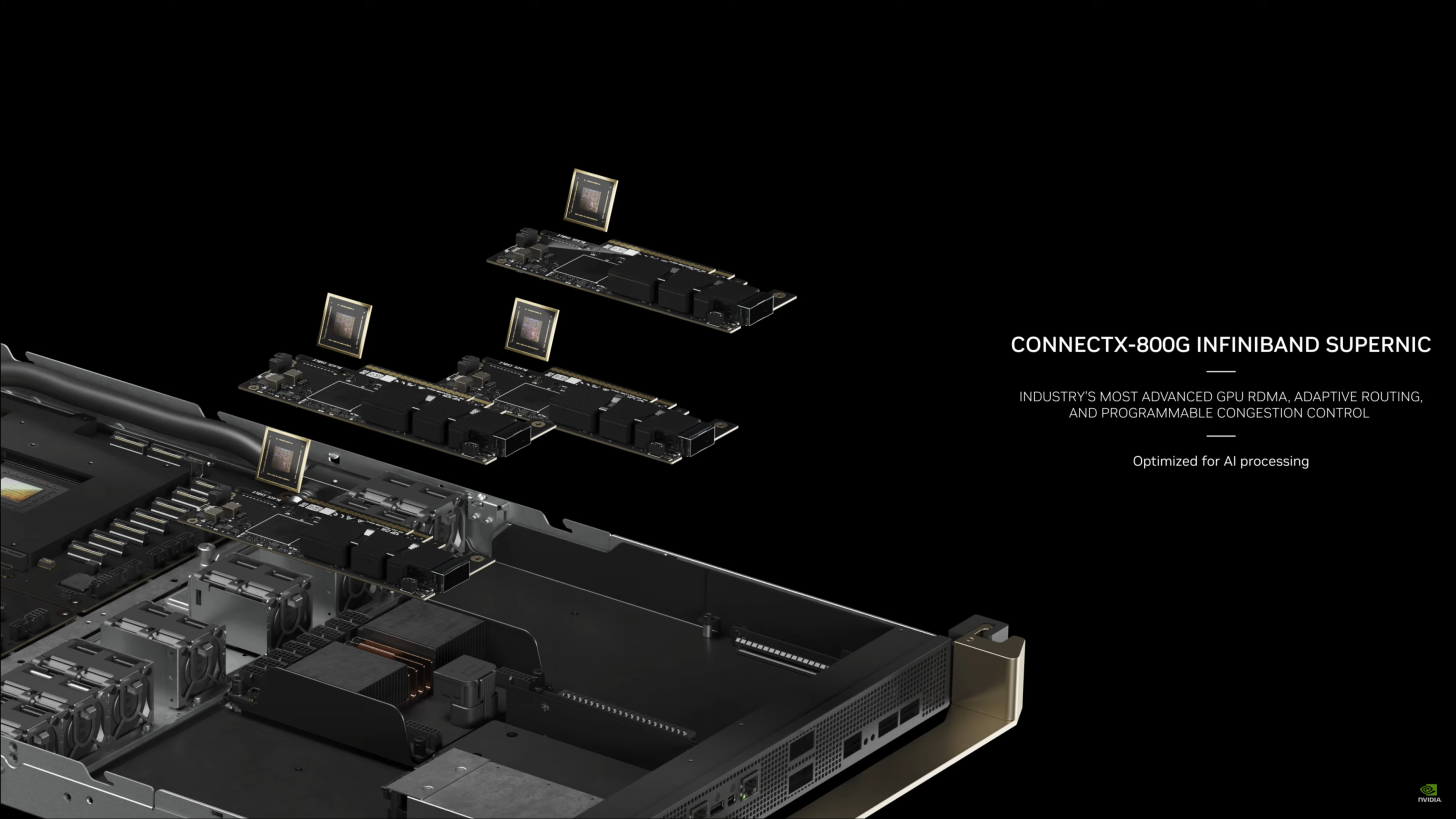

Không chỉ có B200 và CPU Grace, mà Blackwell Compute Node còn trang bị những con chip và bo mạch xử lý chuyên biệt kết hợp lại với nhau với một mục đích duy nhất, đó là tạo ra băng thông bộ nhớ và sức mạnh xử lý AI nhanh nhất. Trong đó bao gồm cầu nối dữ liệu ConnectX-800G Infiniband, DPU Bluefield 3 phục vụ xử lý networking, quản lý bộ nhớ lưu trữ và bảo mật.

Riêng bản thân con chip NVLink Switch cũng là một thứ đáng đề cập, khi nó được ứng dụng tiến trình 4NP của TSMC để trang bị 50 tỷ transistor, vận hành 72 port SerDes (serializer/deserializer) băng thông 200 GB/s, cùng 4 cầu nối NVLink băng thông 1.8 TB/s.

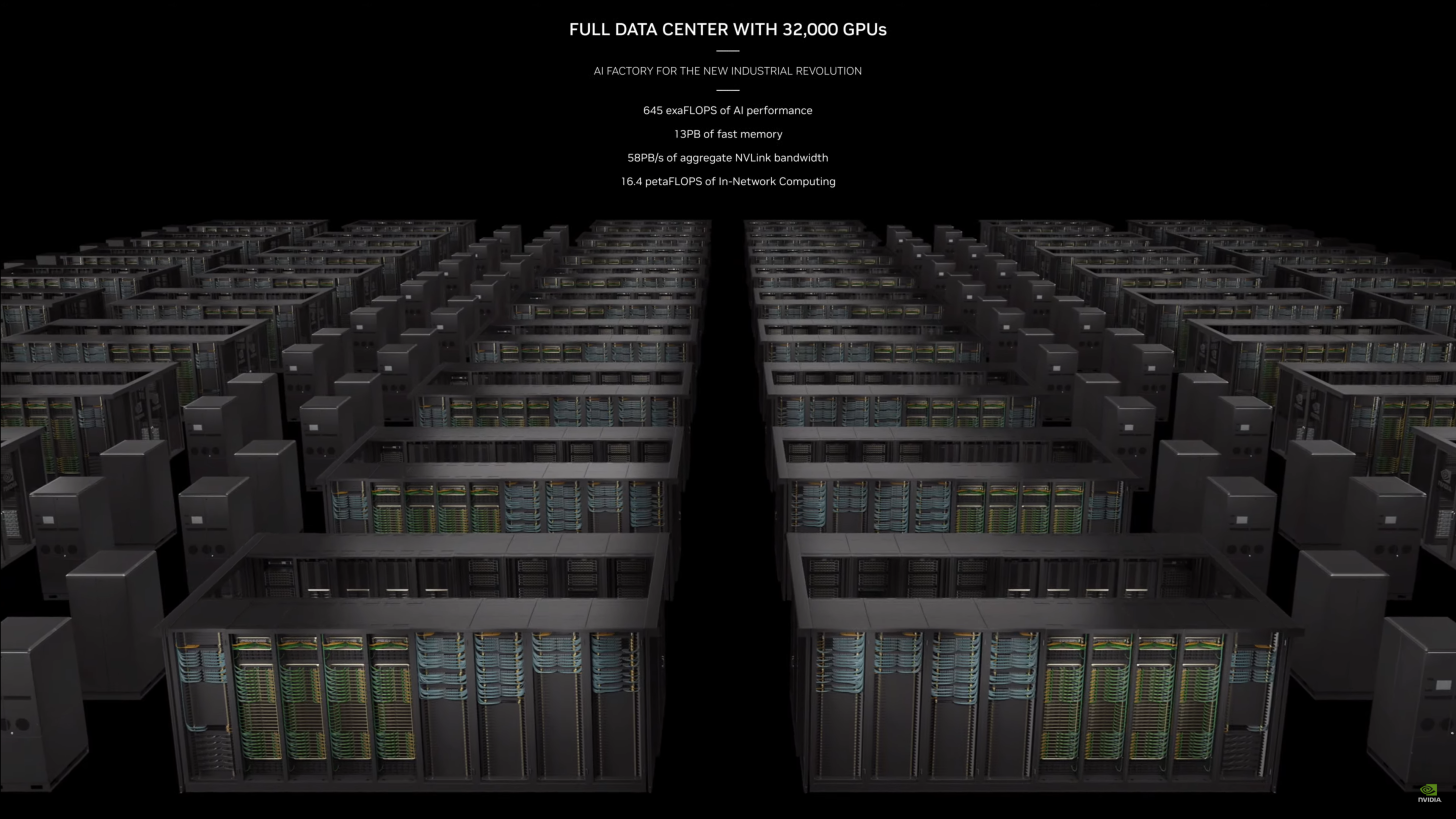

Tối đa, GB200 cho phép tạo ra một data center quy mô khổng lồ với 32 nghìn GPU, 13 petabyte RAM HBM3e, sức mạnh xử lý 645 exaflop, tính riêng hiệu năng xử lý dữ liệu network cũng tính bằng đơn vị petaflop.

Nvidia cho biết, Blackwell GB200 sẽ được trang bị trên những hệ thống DGX Cloud, ra mắt nửa cuối năm 2024. Rồi sau đó, những đơn vị OEM cũng sẽ có những giải pháp máy chủ trang bị những chip xử lý AI thế hệ mới nhất này, bao gồm Dell, Cisco, HPE, Lenovo, Supermicro, Aivres, ASRock Rack, ASUS, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, QCT, Wistron, Wiwynn & ZT Systems.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan