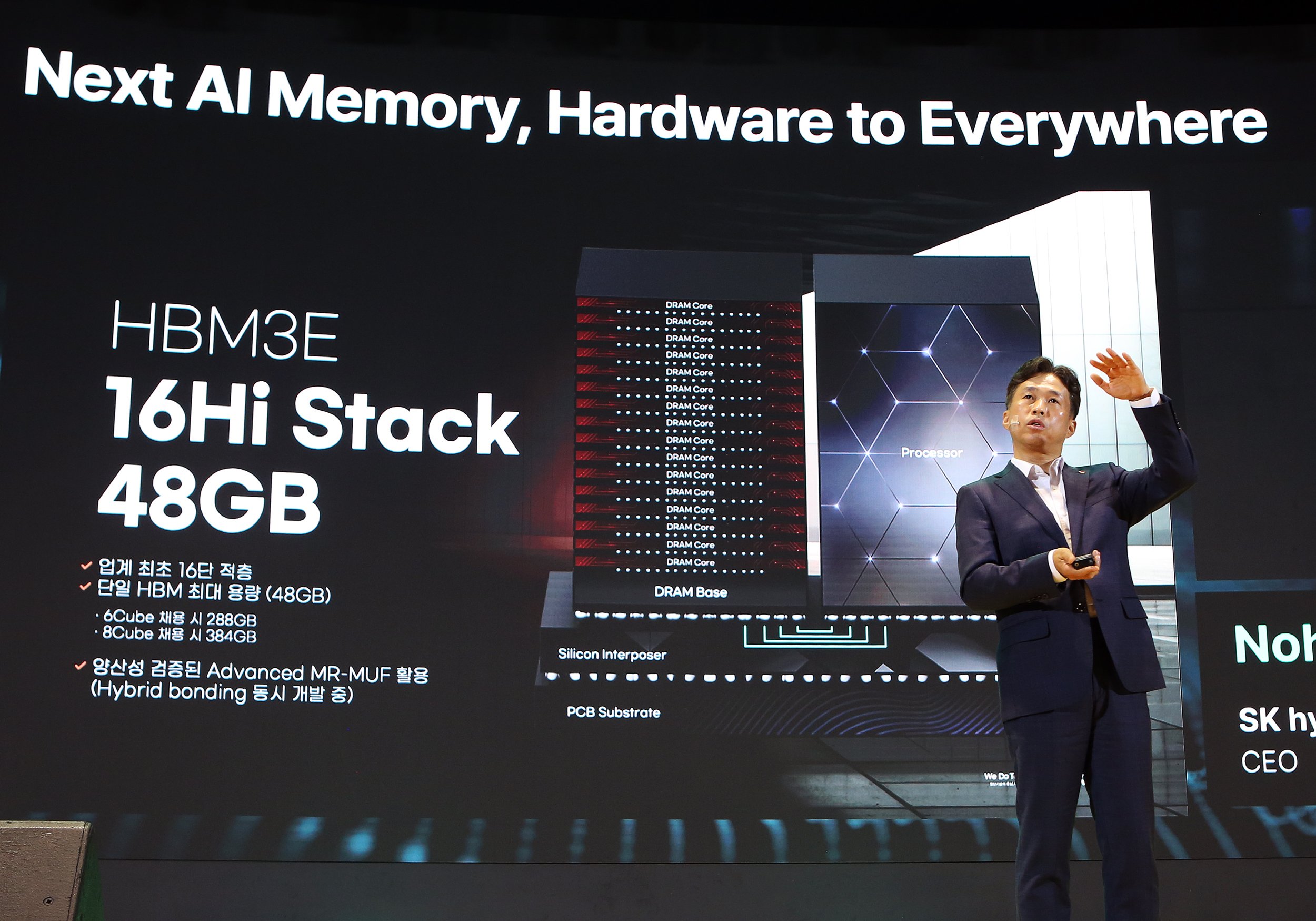

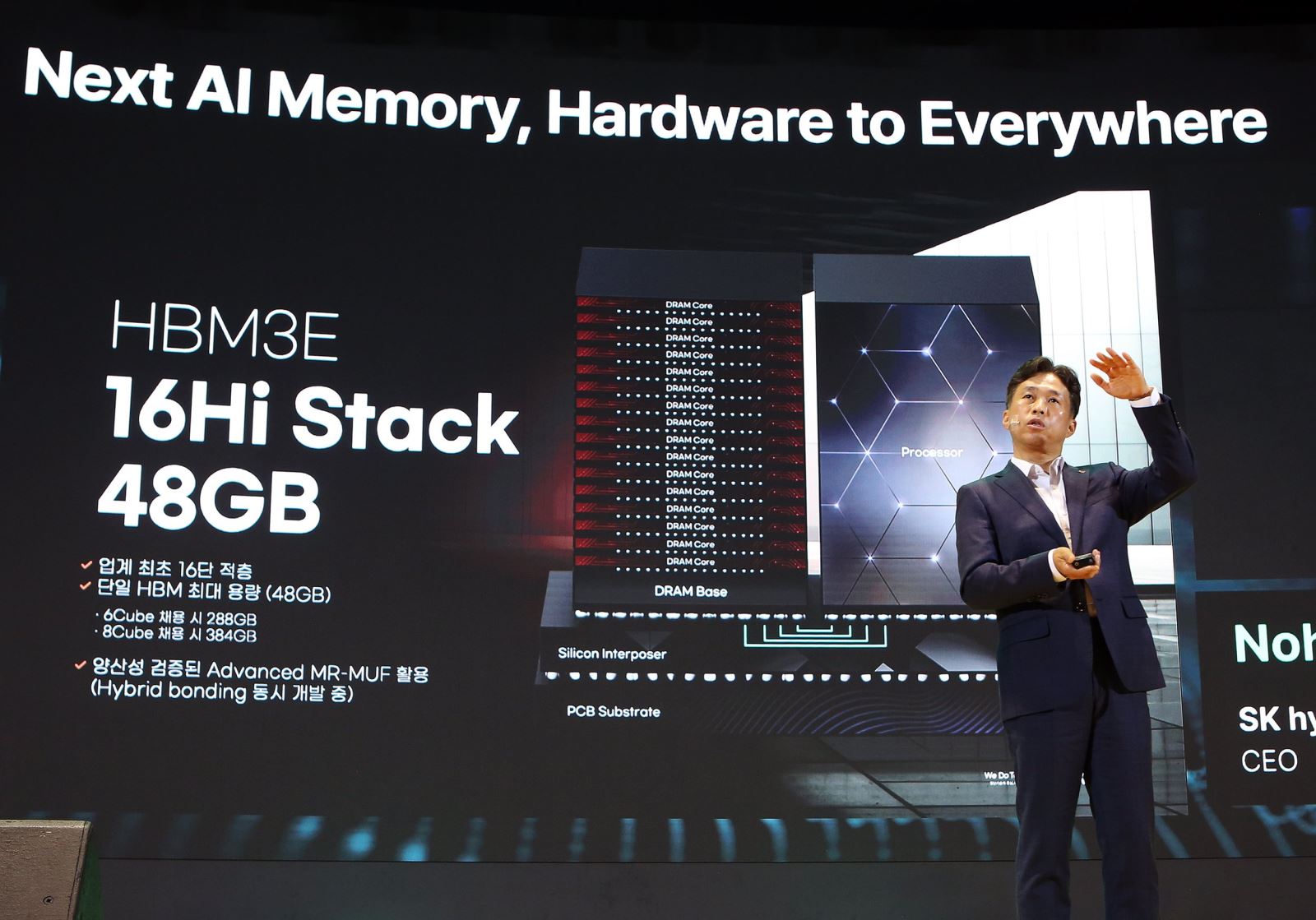

SK hynix sẽ bắt đầu sản xuất chip băng thông cao 16 lớp đầu tiên trên thế giới vào đầu năm 2025

Đây là sản phẩm chip RAM HBM3E xếp chồng 16 lớp có dung lượng tối đa 48GB mỗi con chip đầu tiên trên thế giới. Dự kiến những bản engineering sample đầu tiên của SK Hynix HBM3E 16-Hi stack sẽ đến tay những nhà phát triển chip xử lý vào đầu năm 2025 tới.

Kể từ thế hệ HBM4, dự báo cho thấy nhu cầu chip nhớ HBM xếp chồng 16 lớp sẽ tăng mạnh. Nhưng SK Hynix vẫn phát triển thế hệ HBM3E xếp 16 lớp để đảm bảo ổn định về mặt công nghệ, cùng lúc cho phép họ phát triển được công nghệ ghép die bán dẫn hybrid bonding.

Quy trình Advanced MR-MUF được ứng dụng. Quy trình gia công này đã cho phép tập đoàn này sản xuất thương mại quy mô lớn những chip HBM3E xếp chồng 12 lớp.

Sản phẩm HBM3E 16 lớp là sản phẩm HBM3E cao cấp nhất, vượt trội hơn sản phẩm 12 lớp hiện có. Trong ứng dụng, trên lý thuyết, chip HBM3E xếp chồng 16 lớp cho phép cải thiện 18% hiệu năng huấn luyện mô hình AI, vận hành nội suy các dịch vụ AI tăng 32% hiệu năng so với chip HBM3E 12 lớp.

Cùng với HBM3E và HBM4, SK Hynix cũng đang phát triển module bộ nhớ LPCAMM 2 cho máy tính cá nhân và máy chủ đám mây, dựa trên chip LPDDR5 và LPDDR6 1cnm, tận dụng lợi thế cạnh tranh về tiêu thụ điện năng và hiệu năng xử lý.

SK Hynix cũng đang phát triển SSD chuẩn PCIe 6.0, những SSD chuẩn doanh nghiệp dựa trên công nghệ chip nhớ QLC NAND, và bộ nhớ UFS 5.0 cho smartphone.

Một công nghệ khác đang được phát triển có thể cho phép bộ nhớ hệ thống máy tính và máy chủ thực hiện tính toán, để vượt qua hàng rào gọi là “memory wall.” Những công nghệ như PNM (Processing Near Memory), PIM (Processing In Memory) và Computational Storage có thể giúp chính ổ cứng và chip nhớ có thể xử lý lượng dữ liệu khổng lồ lưu trữ bên trong, từ đó thay đổi cả ngành AI trong tương lai.

SK hynix có kế hoạch cung cấp mẫu HBM3E 16 lớp cho khách hàng vào đầu năm 2025. SK hynix có kế hoạch kết hợp xử lý logic vào khuôn cơ sở cho HBM4 thông qua quan hệ đối tác với một xưởng đúc toàn cầu hàng đầu, đồng thời cũng phát triển các giải pháp lưu trữ tính toán và CXL (compute express link: tiêu chuẩn mở cho giao tiếp tốc độ cao) để đáp ứng nhu cầu về bộ nhớ do AI điều khiển.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan