Mở khóa sức mạnh của máy chủ AI với Mô-đun Bộ nhớ CXL của Innodisk

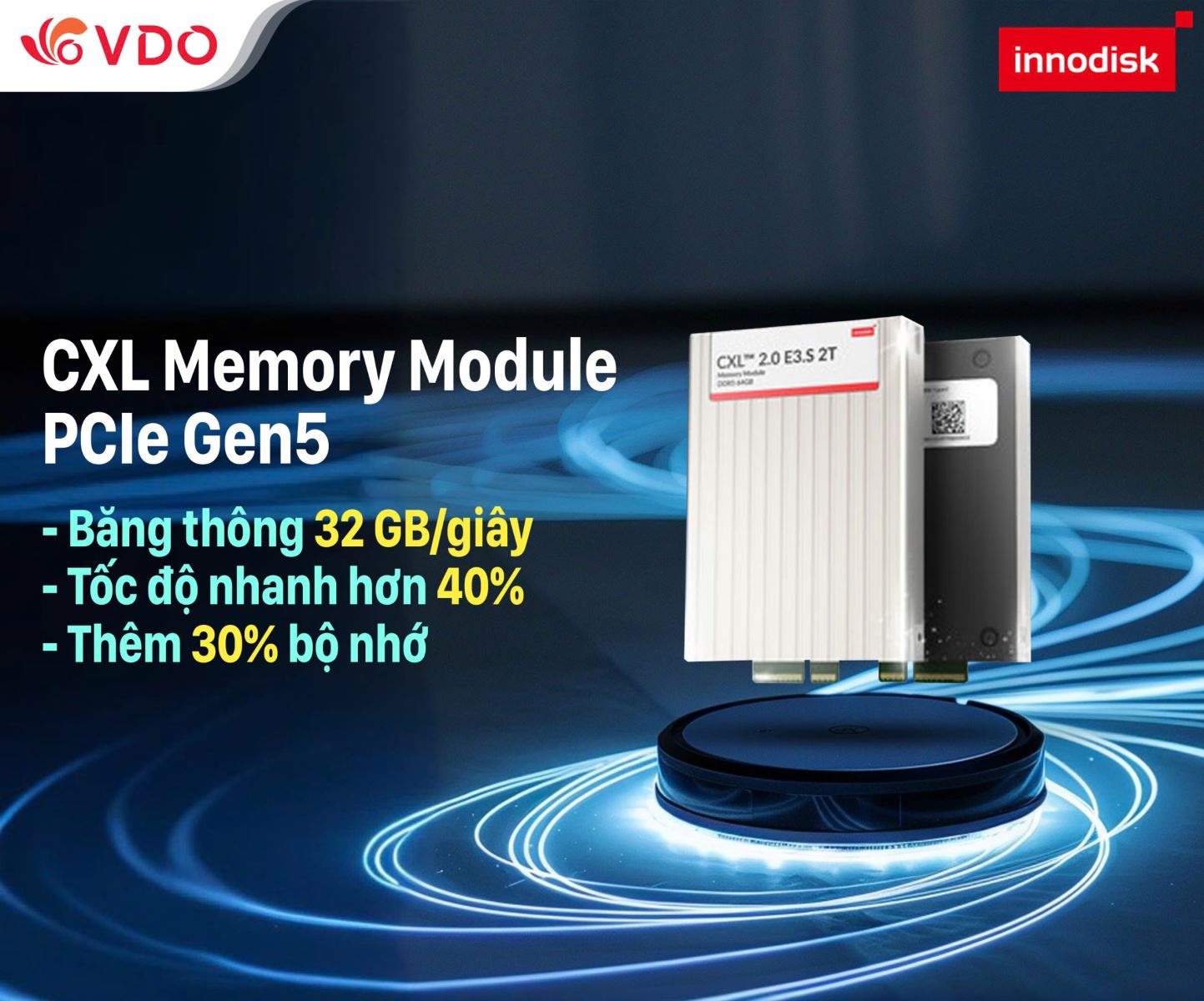

Innodisk giới thiệu Mô-đun Bộ nhớ Compute Express Link (CXL) — một giải pháp cách mạng được thiết kế để mở rộng khả năng bộ nhớ AI và đáp ứng nhu cầu dung lượng bộ nhớ máy chủ đang tăng nhanh chóng.

Sự phức tạp ngày càng tăng của các khối lượng công việc AI đang thúc đẩy các giải pháp bộ nhớ truyền thống đến giới hạn của chúng. Dung lượng bộ nhớ máy chủ hạn chế và các nút thắt cổ chai về bộ nhớ đang kìm hãm tiềm năng tối đa của các ứng dụng AI. Để giải quyết những thách thức này, Innodisk giới thiệu Mô-đun Bộ nhớ Compute Express Link (CXL) — một giải pháp cách mạng được thiết kế để mở rộng khả năng bộ nhớ AI và đáp ứng nhu cầu dung lượng bộ nhớ máy chủ đang tăng nhanh chóng.

Mô-đun bộ nhớ CXL của Innodisk tận dụng giao thức Type 3 và tuân thủ tiêu chuẩn CXL 2.0, hỗ trợ chia sẻ bộ nhớ máy chủ trên nhiều máy chủ. Điều này bao gồm cả các giao thức CXL.io và CXL.mem, giúp mở rộng bộ nhớ có sẵn cho CPU một cách liền mạch.

Mở rộng bộ nhớ ngay lập tức 64GB mỗi mô đun CXL

Trang bị cho máy chủ bốn mô-đun CXL 64GB bổ sung cùng với tám mô-đun DRAM 128GB hiện có, và hưởng lợi từ việc tăng dung lượng bộ nhớ lên đến 30% và băng thông lên đến 40% — được cung cấp bởi mô-đun bộ nhớ CXL tiên tiến.

Nâng cao hiệu suất

Cải thiện hiệu suất hệ thống bằng cách cho phép phân bổ tài nguyên bộ nhớ linh hoạt, giúp cải thiện luồng dữ liệu và giảm thiểu các nút thắt cổ chai. Thiết kế này cũng cho phép tích hợp dễ dàng với các hệ thống hiện có, giảm thiểu tối đa chi phí và rủi ro nâng cấp.

Khả năng mở rộng trên nhiều hệ thống

Được hỗ trợ bởi CPU Intel® Xeon® và AMD EPYC™ Gen 4 hoặc cao hơn, mô-đun bộ nhớ CXL cung cấp khả năng tích hợp linh hoạt trên các kiến trúc hệ thống và giúp giảm chi phí nâng cấp.

Hình thức tối ưu và kết nối tốc độ cao

Được thiết kế theo tiêu chuẩn hình dạng E3.S 2T với vỏ hợp kim nhôm bền bỉ, mô-đun CXL đảm bảo tản nhiệt hiệu quả. Mô-đun sử dụng PCIe Gen5 với 8 làn, cung cấp thêm 32 GB/s băng thông để chia sẻ và cung cấp bộ nhớ hiệu quả trên các khối lượng công việc AI, máy học và HPC.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan