HBM3E của Micron là công cụ thay đổi cuộc chơi cho các ứng dụng AI

Toàn bộ nguồn cung bộ nhớ HBM3e trong năm 2024 của Micron đã được bán hết.

Phần lớn nguồn cung bộ nhớ HBM3e trong năm 2025 của Micron cũng đã có khách đặt mua hết. Giám đốc điều hành của Micron - Sanjay Mehrotra - cho biết: “Bộ nhớ HBM của chúng tôi đã bán hết trong năm 2024, đồng thời phần lớn nguồn cung năm 2025 cũng đã được phân bổ xong. Chúng tôi kỳ vọng thị phần của HBM sẽ ngang ngửa với thị phần DRAM tổng thể cũng trong năm 2025.”

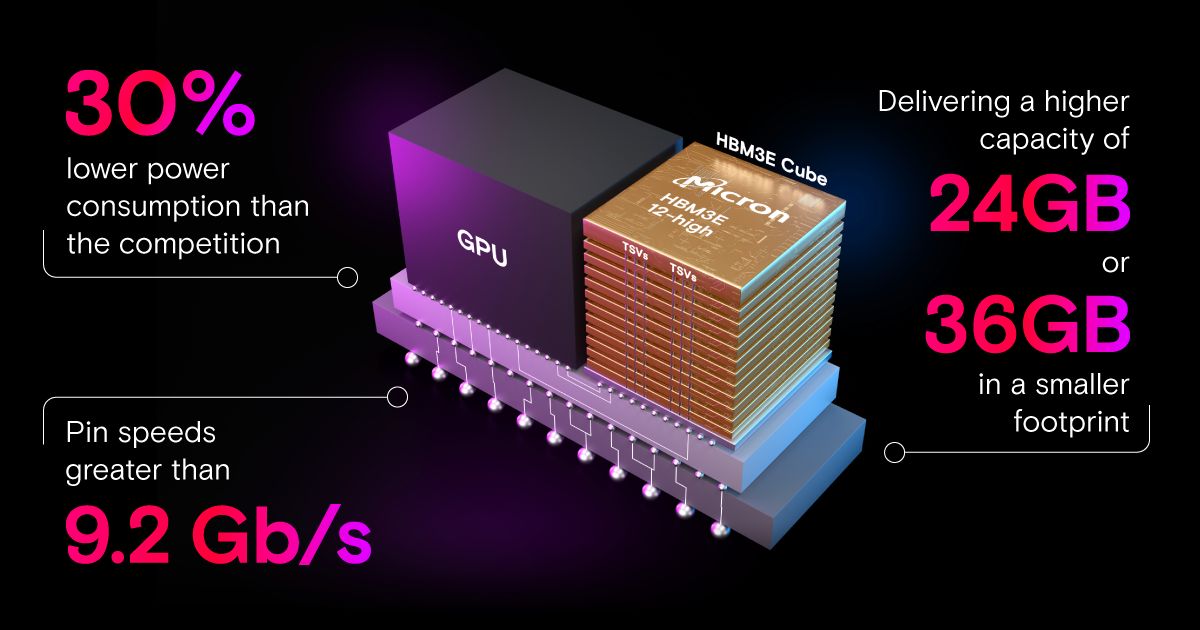

Micron cho biết bộ nhớ HBM3e sẽ được sử dụng trong GPU H200 của NVIDIA dành cho ứng dụng trí tuệ nhân tạo (AI) và điện toán hiệu năng cao (HPC). Bộ nhớ hiệu năng cao HBM3e có dung lượng 24 GB, xếp chồng 8 tầng (8-Hi) dạng khối vuông (cube), cung cấp tốc độ truyền tải dữ liệu tới 9.2 GT/s và băng thông nhớ tối đa hơn 1.2 TB/s. Tổng cộng có 6 cube HBM3e như vậy hỗ trợ cho mỗi NVIDIA H200 GPU, tổng dung lượng 141 GB, băng thông 4.8 TB/s. Dự kiến năm tài chính 2024, doanh thu của HBM sẽ đạt hàng trăm triệu USD. Micron cũng kỳ vọng doanh thu từ HBM sẽ đóng góp tích cực vào lợi nhuận gộp tổng thể, kể từ Q3.

Sanjay Mehrotra nói rằng Micron đã bắt đầu sản xuất mẫu thử nghiệm HBM3e với 12 tầng xếp chồng (12-Hi), tăng dung lượng bộ nhớ thêm 50%, từ đó cho phép huấn luyện các mô hình ngôn ngữ kích thước lớn hơn trong lĩnh vực AI. HBM3e dung lượng 36 GB sẽ được trang bị cho các bộ xử lý AI thế hệ kế tiếp, hãng cũng sẽ bắt đầu tăng tốc sản xuất trong năm 2025.

Được cái này thì mất cái kia, sản xuất HBM liên quan trực tiếp tới sản xuất DRAM, do đó tăng sản lượng HBM đồng nghĩa với khả năng sản xuất chip nhớ DRAM thông thường sẽ bị giảm. Cụ thể HBM3e tiêu thụ lượng wafer gấp cỡ 3 lần so với DDR5 để tạo ra cùng lượng bit nhất định, tính trên cùng tiến trình sản xuất. Micron là nhà sản xuất cung cấp HBM3e thương mại đầu tiên ra thị trường, do đó chiếm lĩnh cũng không phải điều khó hiểu.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan

-9edcb187d68e4.jpg)